Die Bedeutung von Prompt Engineering zur Vermeidung von KI-Halluzinationen

Mit den verfügbaren Plattformen müssen Sie bei der Erstellung eines Prompts nicht mehr bei Null anfangen. In der Microsoft Adoption Sample Solutions Gallery sind bereits Prompts-Beispiele verfügbar. Es ist jedoch sehr wichtig zu wissen, wie man einen gute Prompt schreibt. Es kann hilfreich sein, mit etwas zu beginnen, das Sie schon auf halbem Weg weiterbringt.

In diesem Artikel wird erörtert, wie wichtig die Entwicklung von Prompts ist, um zu verhindern, dass Systeme mit künstlicher Intelligenz falsche oder phantasievolle Informationen erzeugen, auch bekannt als Halluzinationen. Der Text hebt auch hervor, dass gut gestaltete Prompts die Qualität der KI-Antworten verbessern können. Damit können sie genauer und relevanter werden und die Wahrscheinlichkeit von Halluzinationen verringern.

Bei diesem Ansatz betonen wir die potenziellen Auswirkungen von Halluzinationen auf Geschäftsanwendungen, einschliesslich Fehlentscheidungen, Umsatzeinbussen und Reputationsschäden. Ausserdem weisen wir auf den Bedarf an menschlicher Validierung und robusten, zeitnahen technischen Verfahren auf, um die Vertrauenswürdigkeit von KI-Systemen in der Umweltkritik sicherzustellen.

Prompt Engineering

Bei generativen KI-Systemen, wie z. B. Large Language Models (LLMs), sind die Anweisungen, die dem Modell gegeben werden, um eine Antwort hervorzurufen (Prompts), von grösster Bedeutung. Die Produktion falscher oder phantasievoller Informationen, die nichts mit der Realität zu tun haben, ist eine der grössten Herausforderungen für Techniker, die diese Modelle entwickelt und in kritischen Szenarien anwendet.

Prompt Engineering mindert diese Fehler im Kontext von Unternehmensanwendungen erheblich. Insbesondere wenn diese Modelle in Unternehmensprozesse integriert werden, die eine hohe Genauigkeit erfordern, wie z. B. CRM-, ERP– und fortschrittliche Datenanalysesysteme.

Vorteile eines Prompt Engineerings

- Ein gut formulierter Prompt kann genauere und relevantere Antworten von einem KI-basierten Sprachmodell erzeugen.

- Durch eine effektive Strukturierung der Aufforderungen erhalten Sie die gewünschten Antworten schneller und ohne ständige Umformulierungen.

- Prompt Engineering ermöglicht die Anpassung der Interaktion mit dem KI-Modell an die spezifischen Bedürfnisse einer Zielgruppe oder einer Aufgabe.

Was macht einen guten Prompt aus?

Prompts fungieren als Anweisungen für das KI-Modell (GPT) und bestehen im Allgemeinen aus zwei Hauptteilen: der Anweisung und dem Datenkontext. Die Konzentration auf die wichtigsten Elemente bei der Erstellung von benutzerdefinierten KI-Funktionen ist entscheidend für die besten Antworten.

Gemäss dem Leitfaden des Microsoft AI Builder-Teams für die Entwicklung von Prompts sollte eine Reihe von Elementen Teil Ihrer Prompt sein. Sie sind:

- Aufgabe: Geben Sie eine Anweisung, die dem Generative Pre-trained Transformer (GPT)-Modell mitteilt, welche Aufgabe es ausführen soll.

- Kontext: Beschreiben Sie die Daten, die ausgelöst werden, zusammen mit allen Eingabevariablen.

- Erwartungen: Vermitteln Sie Ziele und Erwartungen bezüglich der Reaktion auf GPT.

- Ausgabe: Helfen Sie GPT, die Ausgabe so zu formatieren, wie Sie es wünschen.

Ein praktisches Beispiel für eine gut formulierte Aufforderung

Unangemessene Aufforderung: „Wie kann ich ein Solution Architect werden?“

Verbesserte Aufforderung: „Entwerfen Sie einen beruflichen Entwicklungsplan, um eine Karriere als Solution Architect in 6 Jahren aufzubauen. Der Plan sollte Ziele und Vorgaben, Ressourcen und Werkzeuge sowie einen Zeitplan für die Aktivitäten enthalten. Formatieren Sie den Plan so, dass er prägnant und praktisch ist, und stellen Sie die Informationen in einer klaren, leicht verständlichen Weise dar.

Eine gute Anleitung kann KI-Halluzinationen verhindern

Eine Halluzination tritt auf, wenn ein Large Language Model (LLM) Informationen erzeugt, die nicht auf realen Fakten oder Beweisen beruhen. Dies kann fiktive Ereignisse, falsche Daten oder irrelevante Ergebnisse beinhalten.

Die Entwicklung effektiver Prompts erfordert ein tiefes Verständnis dafür, wie das Modell Informationen verarbeitet und wo seine Grenzen in Bezug auf Trainingsdaten und Heuristiken liegen. KI-Halluzinationen können durch vage, zu komplexe oder offene Fragen oder Befehle verschlimmert werden, bei denen das Modell Antworten „improvisieren“ kann, die von der Realität abweichen.

KI-Modelle werden anhand grosser Datenmengen trainiert und lernen, Vorhersagen zu treffen, indem sie Muster in diesen Daten erkennen. Die Genauigkeit dieser Vorhersagen hängt jedoch direkt von der Qualität und Vollständigkeit der Trainingsdaten ab. Wenn die Trainingsdaten unvollständig, verzerrt oder fehlerhaft sind, kann das KI-Modell falsche Muster lernen, was zu ungenauen Vorhersagen oder Halluzinationen führt.

So kann beispielsweise ein KI-Modell, das auf einem medizinischen Bilddatensatz trainiert wurde, lernen, Krebszellen zu erkennen. Wenn der Datensatz jedoch keine Bilder von gesundem Gewebe enthält, kann das KI-Modell fälschlicherweise vorhersagen, dass gesundes Gewebe krebsartig ist.

Was verursacht KI-Halluzinationen?

- Fehlen eines klaren Kontexts: Wenn dem Sprachmodell der Kontext fehlt, kann es Antworten erfinden.

- Zweideutige Anfragen: Vage Fragen können zu zufälligen oder ungenauen Antworten führen.

- Lange Generierungsdauer: Je länger die Antwort generiert wird, desto grösser ist die Wahrscheinlichkeit von Halluzinationen.

- Kein verbesserter Wiederherstellungsprozess: LLMs ohne Zugriff auf externen Quellen – wie Datenbanken oder Suchmaschinen – können Fehler produzieren, wenn sie spezifische Informationen generieren müssen.

Wie kann man verhindern, dass KI Halluzinationen erzeugt?

Die Erstellung guter Prompts kann der KI helfen, validere und genauere Inhalte zu generieren. Dieser Prozess wird als Immediate Engineering bezeichnet. Hier finden Sie einige Techniken zur Erstellung guter Prompts mit Beispielen aus der Praxis:

- Trainieren Sie Ihre KI nur mit relevanten und spezifischen Daten, die für die Aufgabe relevant sind, die das Modell ausführen soll.

- Begrenzen Sie die möglichen Ergebnisse, die das Modell vorhersagen kann, zum Beispiel durch Techniken wie die „Regularisierung“, die das Modell für extreme Vorhersagen bestraft.

- Erstellen Sie ein Modell, an dem sich Ihre KI orientieren kann, wenn sie Vorhersagen trifft. Das Modell sollte Elemente wie einen Titel, eine Einleitung, einen Hauptteil und eine Schlussfolgerung enthalten.

- Setzen Sie klare Erwartungen, um das Modell auf bestimmte Informationen zu lenken und die Wahrscheinlichkeit von Halluzinationen zu verringern. Verwenden Sie eine spezifische Sprache, die das Modell leitet. Konzentrieren Sie sich auf bekannte Datenquellen oder tatsächliche Ereignisse und bitten Sie um Zusammenfassungen oder Umschreibungen von bekannten Quellen.

- Teilen Sie komplexe Aufforderungen auf in kleinere, spezifischere Teile, damit sich das Sprachmodell auf einen engeren Bereich konzentrieren kann.

- Verlangen Sie eine Überprüfung, indem Sie das LLM auffordern, die Quelle seiner Aussagen zu nennen. Dies führt dazu, dass das Modell fundiertere und zuverlässigere Antworten liefert.

- Verwenden Sie die Gedankenkette (Chain of Thought, CoT), indem Sie das Modell durch logische Schritte leiten. Sie können den Weg der Argumentation kontrollieren und dem Modell helfen, genaue Schlussfolgerungen zu ziehen.

Die Auswirkungen von Halluzinationen auf Geschäftsanwendungen

Wenn KI falsche oder irreführende Informationen generiert, kann dies zu Fehlentscheidungen, Umsatzeinbussen, Rufschädigung und sogar zu rechtlichen Problemen führen. Das trifft insbesondere für Branchen zu, die bei der Entscheidungsfindung auf genaue Daten angewiesen sind, wie z. B. im Finanz-, Gesundheits- und Rechtswesen.

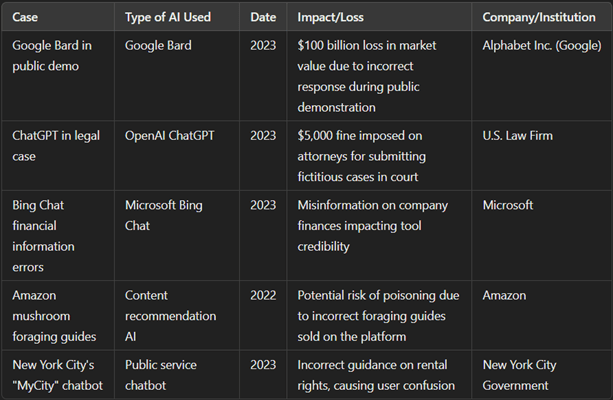

Mehrere Benchmarks weisen auf reale Vorfälle hin, bei denen KI-Halluzinationen zu spürbaren Verlusten geführt haben, darunter Kundensupportsysteme, die falsche Ratschläge erteilten, und Kreditanalysetools, die falsche Finanzprognosen abgaben.

Diese Fälle verdeutlichen, wie wichtig strenge Kontrollen und menschliche Validierung sind, um die Risiken von Halluzinationen in Geschäftsanwendungen zu mindern, insbesondere wenn die Verluste erhebliche Summen erreichen können. Die folgende Tabelle zeigt, wie sich KI-Halluzinationen direkt auf die Effizienz und das Vertrauen in Unternehmenslösungen auswirken.

Fazit

Prompt Engineering ist unerlässlich, um Halluzinationen in KI-Systemen zu verhindern und eine genauere und kontrollierte Datenproduktion zu gewährleisten, die für sensible Geschäftsbereiche geeignet ist. Durch den strategischen Einsatz von Prompt-Engineering-Techniken können Lösungsarchitekten und KI-Experten den Spielraum für Fehler verringern und KI-Modelle schaffen, die einen echten Mehrwert für die Unternehmen darstellen, ohne die Integrität kritischer Daten und Prozesse zu gefährden. Auf diese Weise erhöht Prompt Engineering die Zuverlässigkeit von KI-Anwendungen und positioniert sie als grundlegendes Element für die sichere und effiziente digitale Transformation von Unternehmen.

Möchten Sie mehr darüber erfahren, wie Unternehmen ihre Geschäftsprozesse mit Microsoft KI transformieren? Laden Sie jetzt Microsoft KI-Lösungen in Geschäftsprozessen: Ausblick 2025 herunter.

Kontaktieren Sie uns noch heute, um zu erfahren, wie KI-Lösungen wie Microsoft Dynamics 365 die Effizienz steigern und Ihre digitale Transformation beschleunigen können.